Os quatro elementos críticos da arquitetura de segurança.

Para entender melhor a natureza da arquitetura de segurança, é útil vê-la em quatro contextos críticos.

Não há arquitetura de segurança autônoma

Um grande componente da arquitetura de segurança é que não existe uma arquitetura de segurança independente. É uma "preocupação transversal". Isso significa que há um aspecto de segurança em cada domínio de arquitetura empresarial. Por exemplo: no contexto do seu negócio, quando você pensa em software corporativo, ele terá um componente de segurança. Isso pode ser considerado parte da sua arquitetura e operações de segurança.

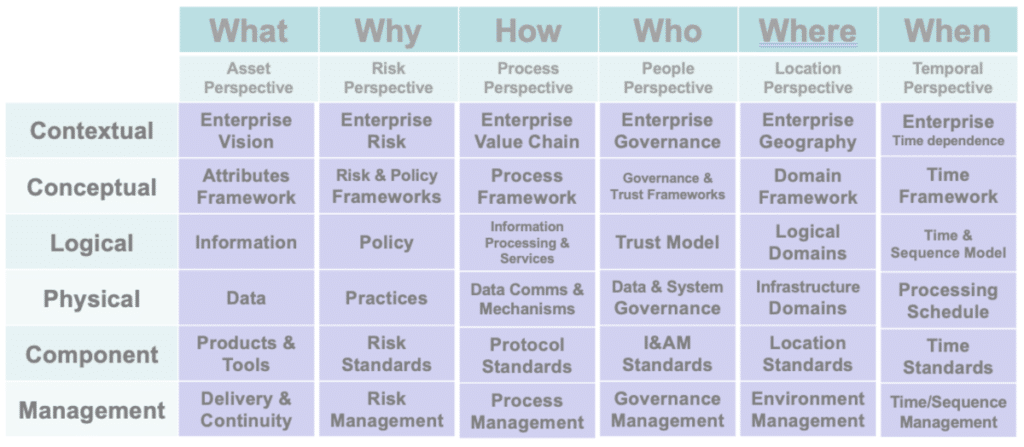

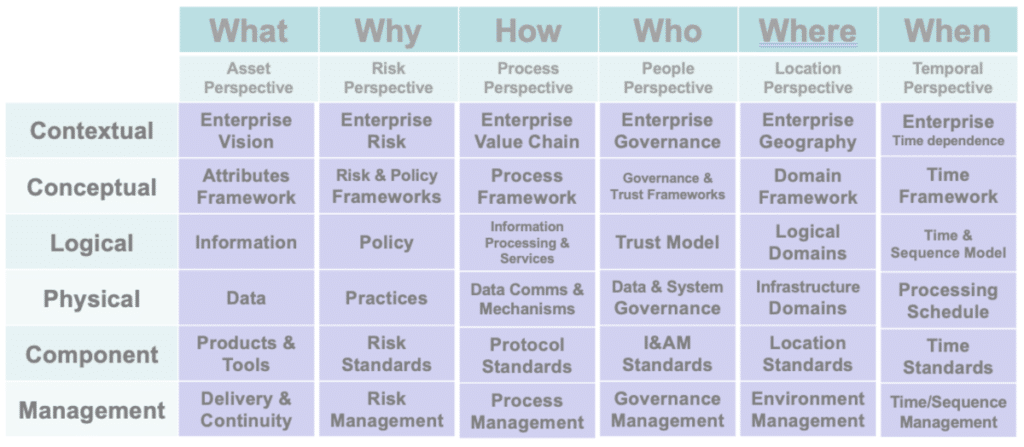

O Modelo SABSA

A melhor prática para arquitetura de segurança é SABSA. SABSA é uma estrutura de arquitetura de segurança da informação corporativa orientada a riscos para dar suporte às principais atividades empresariais. Embora não esteja diretamente relacionada à Estrutura Zachman, O SABSA utiliza a estrutura central. A principal característica do modelo SABSA é que tudo deve ser elaborado a partir de um estudo das necessidades de segurança do negócio, especialmente aquelas em que a segurança serve como um facilitador para o desenvolvimento e a exploração de novas perspectivas de negócios.

O processo analisa as demandas do negócio desde o início e desenvolve uma cadeia que pode ser rastreada ao longo das fases de estratégia e conceito, design, implementação e gerenciamento e mensuração contínuos do ciclo de vida para garantir que o mandato do negócio seja mantido. O método é apoiado por ferramentas de estrutura baseadas em experiências reais.

O modelo SABSA é de natureza geral e pode ser usado como ponto de partida para qualquer organização; mas, ao passar pelo processo de análise e tomada de decisão sugerido por sua estrutura, torna-se específico para cada empresa e, eventualmente, altamente personalizado para um modelo de negócio específico. Torna-se a arquitetura de segurança corporativa e é fundamental para o sucesso do programa estratégico de gestão da segurança da informação da organização.

A equipe da Conexiam trabalhou com o The Open Group e o Instituto SABSA para integrar a estrutura EA padrão da indústria, TOGAF, com SABSA. Baixe uma cópia de Integrando Risco e Segurança com Arquitetura Empresarial para obter mais informações.

É tudo uma questão de gestão de riscos

Arquitetura de segurança é sobre gerenciamento de riscos. Risco é o efeito da incerteza no cumprimento de todos os objetivos do seu negócio. A incerteza advém da perda de uma oportunidade e do impacto de ameaças potenciais. A arquitetura de segurança não resulta necessariamente em proteção contra uma ameaça. Um elemento de gestão de riscos deve estar presente.

A prática de controlar riscos associados ao uso da tecnologia da informação é conhecida como gestão de riscos de segurança da informação, ou ISRM. Ela envolve reconhecer, analisar e responder a ameaças à confidencialidade, integridade e disponibilidade dos ativos de uma organização. O objetivo final dessa abordagem é abordar os riscos de acordo com a tolerância a riscos da empresa. As empresas devem tentar determinar e assumir um limite de risco geral aceitável para suas organizações, em vez de esperar eliminar todos os riscos potenciais.

Normalmente, o gerenciamento de riscos como parte da arquitetura de segurança envolverá a identificação de ativos, a identificação de vulnerabilidades potenciais, a identificação de ameaças, a descoberta de controles e a realização de avaliações completas regularmente.

Segurança e arquitetura empresarial precisam ser integradas

O desenvolvimento da Arquitetura de Segurança precisa ser totalmente integrado ao desenvolvimento de uma arquitetura corporativa.

Na maioria das empresas, melhorar a segurança é uma tarefa impossível. Em vez de desenvolver uma arquitetura de segurança integrada, um trabalho aleatório é realizado para proteger partes do negócio. Muitas vezes, outras partes do negócio estão sujeitas a fácil penetração ou violação. Proporcionar um ambiente seguro requer medidas preventivas, investigativas e corretivas.

Muitos profissionais convencionais de segurança da informação consideram a arquitetura de segurança nada mais do que a presença de regras de segurança, controles, ferramentas e monitoramento.

Todos os profissionais de segurança devem estar cientes dos objetivos de negócios e se esforçar para alcançá-los, projetando controles de segurança apropriados que possam ser facilmente justificados às partes interessadas e relacionados ao risco do negócio. Estruturas corporativas, como SABSA e Padrão TOGAF, auxilia no alinhamento dos requisitos de segurança e negócios.

TOGAF é um estrutura de arquitetura empresarial. Os arquitetos corporativos usam o Método de Desenvolvimento de Arquitetura TOGAF (ADM) para focar mudanças, reduzir erros e alinhar a TI com as divisões de negócios para criar resultados de alta qualidade.

Dê uma olhada em nosso TOGAF vs. SABSA artigo para pensar no TOGAF mais SABSA. Amplie sua arquitetura empresarial com risco e segurança de classe mundial.